W związku z nadchodzącymi dość dużymi zmianami w portalu społecznościom Facebook, chciałbym zwrócić uwagę na pewien negatywny aspekt tych “nowości” związany z kolejnym ograniczaniem prywatności. Zacznijmy od rzeczowego podsumowania, o co w ogóle chodzi - artykuł w serwisie Mashable.com:

Oraz wątpliwej kwestii ciasteczek przechowywanych przez serwis nawet po wylogowaniu się - artykuł w serwisie MakeUseOf.com:

Krótko mówiąc, chodzi o to, że:

Rewelacje właśnie wprowadzane przez Facebook, mogą spowodować, że jeśli użytkownik nie ogarnia w 100% tego jak działają i jaki skutek mają opcje ustawione w jego profilu, to może dojść do sytuacji, że jego profil będzie rozgłaszał bez jego świadomości informacje o tym, jakie przegląda on strony internetowe

Facebook przechowuje pewne informacje o użytkowniku, w postaci ciasteczka - pliku tekstowego zapisanego w przeglądarce - nawet po jego wylogowaniu się z serwisu. Oficjalne wyjaśnienia, a jakże by inaczej, zapewniają użytkowników, że to dla ich dobra. Ale nie sposób oprzeć się konkluzji, że informacje te mogą być wykorzystywane na jeszcze inne sposoby, np. przez wszelkie rewelacyjne, ostatnio modne wtyczki na przeróżnych stronach integrujące się z Facebook’iem

W czerwcu 2010 roku opublikowałem post w którym wyjaśniam moje podejście do kwestii związanych z bezpieczeństwem przeglądania stron internetowych. Wiele osób zarzucało mi wtedy, że jestem paranoikiem i przesadzam używając na co dzień dwóch przeglądarek internetowych. W kontekście opisanych wyżej “nowości”, albo raczej potencjalnych kłopotów, mój pomysł odizolowania zwykłego przeglądania stron internetowych od bycia zalogowanym w wszelkiego rodzaju serwisach wydaje się jeszcze bardziej uzasadniony. Mówiąc wprost, przy zastosowaniu moich pomysłów te problemy w ogóle nie istnieją. Facebook w żaden sposób nie dowie się, co robię na innych stronach, bo robię to w innej przeglądarce.

Ponieważ wspomniany post jest napisany językiem technicznym, krótko opiszę raz jeszcze co jest istotą mojego pomysłu:

Zainstalowanie drugiej przeglądarki internetowej, której używa się tylko do logowania w serwisach takich jak np. Google Gmail, Facebook itd.

Nie można mieć uruchomionych dwóch przeglądarek obok siebie. Nowo otwierane okna należą do tej samej instancji programu. Potrzebny jest oddzielny program. Osobiście używam przeglądarki Seamonkey, ponieważ moją główną przeglądarką jest Firefox. Ale nic nie stoi na przeszkodzie, żeby były to inne kombinacje np. Firefox i Opera, Firefox i Internex Explorer albo najciekawsze: Firefox i Firefox — tak jest to możliwe. Istnieje program o nazwie Palemoon, który jest po prostu Firefox’em tylko, że skompilowanym specjalnie dla nowoczesnych komputerów. Ale jest oddzielnym programem, który może być uruchomiony obok zwykłego Firefox’a

Istotne jest ustawienie w obu przeglądarkach czyszczenia ciasteczek po zamknięciu programu. Tak naprawdę ciężko mi jest uzasadnić sens przechowywania ciasteczek, poza wyjątkowymi przypadkami gdy np. ktoś gra w jakieś gry online, które w ten sposób zapisują wyniki. W większości przypadków utracimy jedynie możliwość logowania bez podawania hasła w niektórych stronach, która i tak jest niebezpieczna. Z resztą to można obejść zapamiętując swoje hasło w menedżerze haseł - wychodzi na to samo. Co zyskujemy? Duże utrudnienie w identyfikowaniu nas i zbieraniu informacji o nas. Takie np. Google wyświetla inne wyniki wyszukiwania gdy pozbiera trochę informacji o tym gdzie klika użytkownik. Bardzo nie lubię sytuacji gdy komputer wie lepiej co jest dla mnie dobre, wolę za każdym razem mieć “czyste” wyniki wyszukiwania i jawić się wyszukiwarce za każdym razem jako “świeży” użytkownik

Istotna jest aktualność używanych przeglądarek, o którą należy dbać

Życzę szybkiego zorientowania się jak działają Facebook’owe “rewelacje”

Czytam sobie dzisiaj newsy z serwisu OSnews.pl i widzę takie coś:

O niskim poziomie większości polskich mediów wiem nie od dziś, ale od dziś chyba zacznę ograniczać listę serwisów internetowych z branży IT, które stanowią dla mnie źródło bieżących informacji. Do niektórych mam już poważne wątpliwości. Zastanawiam się, komu przyszło do głowy “120% czasu procesora”. Nie sądzę, żeby tego typu informacje były podawane przez firmę Adobe, podejrzewam, że jest to dziennikarska interpretacja. Moim zdaniem niedorzeczna. Chyba, że pojawiły się jakieś nowe jednostki czasu, tudzież nowa definicja procenta, o której nie wiem. Jeśli tak, bardzo proszę oświecić mnie w komentarzach.

Jak można poświęcać 120% czasu na coś? Czy jeśli pracuję 8 godzin dziennie, mogę powiedzieć, że jakieś zadanie wykonywałem przez 120% mojego czasu pracy? Czyli wykonywałem je przez 9,6 godziny. Ale przecież pracuję 8 godzin, czyli nie mogłem pracować 9,6 godziny. dochodzimy do sprzeczności. Czy dla kogoś doba ma więcej niż 24 godziny?Może ta różnica to właśnie te procenty ponad 100 ;) ? W informatyce, o ile wiem, czas liczy się w ten sam sposób jak w każdej innej dziedzinie. Współcześnie używane w większości komputerów systemy operacyjne to tzw. systemy z podziałem czasu. System operacyjny wyznacza pewne krótkie okresy, rzędu milisekund, które przydziela procesom (proces to program podczas działania) na to, by mogły być wykonywane przez procesor. Gdy procesor “nudzi się”, to jest, gdy wszystkie procesy wykorzystały swoje kwanty, aby zrobić to, co miały do zrobienia, system przydziela do wykonywania na procesorze tzw. proces bezczynności, który “wykonuje nic nie robienie” (w pewnym uproszczeniu). Fachowo nazywa się to instrukcja NOP - no operation. Zajętość procesora oznacza tak naprawdę ile czasu zajmowało nic nie robienie w stosunku do wykonywania procesów. Zajętość nigdy nie może wynosić 0, ponieważ cały czas wykonywany jest kod samego systemu operacyjnego, który chociażby zarządza wspomnianym przydzielaniem czasu. Zajętość może wynosić 100%, taka sytuacja ma miejsce wtedy, gdy jest dużo procesów, które intensywnie pracują i procesor nie spędził nawet ułamka chwili na nic nie robieniu. W takiej sytuacji krytycznym zadaniem systemu operacyjnego jest sprawiedliwy podział czasu, tak, aby wszystkie procesy dostały chociaż na króciutką chwilę szansę wykonania na procesorze i żeby żaden z nich nie “zawłaszczył” sobie całego czasu procesora blokując na przykład sam system operacyjny, który tym wszystkim zarządza. To jak zrealizować tę sprawiedliwość jest opisane w wielu opasłych księgach na temat teorii konstrukcji systemów operacyjnych, z których osobiście polecam Abraham Silberschatz “Podstawy systemów operacyjnych”. Mając takie wyobrażenie o działaniu komputera naprawdę trudno mi jest wyobrazić sobie, co może oznaczać powyższe 120% czasu. Utwierdza mnie to tylko w przekonaniu, że w tematyce związanej z komputerami jest coraz więcej pseudo-fachowców, którzy de facto nie mają pojęcia, o czym mówią.

Aktualizacja - 23.01.2011

W międzyczasie spotkałem się wyżej opisaną konwencją podawania wskaźnika użycia procesora. Okazuje się, że przyjmuje ona jako 100% pojedynczy procesor (rdzeń), więc gdy w systemie jest ich więcej, wynik może przekroczyć 100% w przypadku aplikacji które wykonują intensywne obliczenia wykorzystując wiele wątków/procesów. Konwencja ta jest używana np. przez Unix’owe narzędzie time. Poniżej przedstawiam wynik działania time’a dla specjalnego narzędzia zrównoleglającego wykonywanie skryptów: ppss.

$ /usr/bin/time ppss -d /opt/Adobe -c 'tar -cvjf ./adobe.tar.bz'

255.25user 440.59system 7:05.44elapsed 163%CPU (0avgtext+0avgdata 0maxresident)k

2992inputs+6384outputs (20major+9669583minor)pagefaults 0swaps

Tak więc moje zarzuty o bezsensowności okazały się trochę przedwczesne. Pierwszą część tego wpisu jednakże pozostawiam w niezmienionej postaci, ponieważ i tak uważam, że konwencja ta jest myląca, a oprócz tego ktoś z czytelników może mieć podobne spostrzeżenia i wątpliwości do moich, gdy zobaczy liczbę większą od 100%.

Wpis ten jest rozwinięciem pomysłów, które opisałem w ubiegłym roku tutaj. Wraz z dynamicznym rozwojem zjawisk zachodzących w obrębie szeroko rozumianego Web 2.0, stwierdziłem, że konieczne jest wprowadzenie dodatkowych rozwiązań oraz wyrobienie nowych nawyków w stosunku do tego, co zostało opisane wcześniej.

Obawiam się Cross-site-scripting

O tym czym jest, jak wygląda i co powoduje XSS pokazywałem na przykładzie słynnych stron rzekomo “usuwających” funkcjonalność “Śledzika” z serwisu NK. Generalnie chodzi o to, że gdy jestem zalogowany na pewnej stronie internetowej, np. NK, albo FB w innych kartach przeglądarki zwykle oglądam też jeszcze inne strony. Może się zdarzyć tak, że gdzieś kliknę w pewien złośliwy link, który prowadzi do strony ze skryptem. Ten skrypt z kolei może wykonać bez mojej wiedzy i zgody pewną czynność wykorzystując to, że jestem właśnie zalogowany na swoim koncie. W opisywanym przeze mnie przykładzie było to automatyczne wklejenie komunikatu do “Śledzika”, który pokazywał się naszym znajomym. Innym tego typu przykładem jest strona “110 Hottest Women in The World”, która namawia do “polubienia” jej na FB, po czym bez naszej wiedzy i zgody wkleja się do strumienia aktualności uwidaczniając się wszystkim naszym znajomym. Odrębną kwestią jest konsekwentna nieufność wobec wszelkich stron, które namawiają nas do “polubienia” na FB albo sugerują ściągnięcie i uruchomienie jakiegoś pliku, po to, żeby coś ciekawego zobaczyć. Takie coś świadomy użytkownik natychmiast i bez zastanowienia ignoruje, ponieważ od razu widać, o co tak naprawdę chodzi. Na dzień dzisiejszy tego typu złośliwe sztuczki nie powodują większych szkód, ponieważ “jedynie” umieszczają pewne treści na naszej tablicy FB. Tym, co mnie martwi jednak, są: po pierwsze potężne możliwości rozprzestrzeniania się, po drugie możliwości ewoluowania tego typu technik i łączenia ich np. z lukami typu zero-day. Zauważmy, że jest bardzo prawdopodobne, że w tym przypadku sporo osób kliknie w złośliwy link. Wszak pojawił się on u naszego znajomego na tablicy, to już samo w sobie budzi zaufanie, ponadto skoro się tam pojawił, to znaczy, że ten znajomy uważa, że jest to coś fajnego, co warto zobaczyć. Jest to bardzo sprytny chwyt social-engineering, który skutecznie zwiększa grono potencjalnych ofiar. Niewykluczone, że w przyszłości pojawią się ataki, które tę sprytną sztuczkę będą wykorzystywać tylko do “rozmnażania się”, a ich sednem będzie exploit wykorzystujący nienaprawiony jeszcze błąd w przeglądarce powodujący zdalne wykonanie kodu. Innym możliwym scenariuszem jest “wstrzykiwanie” bez naszej wiedzy i zgody treści niecenzuralnych, żeby “uderzyć” w reputację użytkownika.

W związku z powyższym proponuję wdrożyć w prosty sposób zasadę izolacji i używać na co dzień przynajmniej dwóch przeglądarek internetowych jednocześnie. Jednej z nich używać jedynie do usług, w których zwykle jesteśmy cały czas zalogowani jak np. GMail czy FB, drugą natomiast do zwykłego przeglądania stron internetowych. Zgodnie z tym, co opisywałem w ubiegłym roku, oczywiście obie przeglądarki uruchamiam przez Sandboxie. Ponadto w tej przeznaczonej dla usług korzystam z dodatku NoScript, którym ograniczam wykonywanie skryptów JavaScript tylko do stron z usługami np. google.com czy facebook.com i żadnych innych. Myślę, że jest to skuteczny kompromis pomiędzy wygodą i w miarę przyzwoitym poziomem ochrony. Korzystanie w “przeglądarce do przeglądania” z NoScript mogłoby być uciążliwe, ponieważ JavaScript jest jednak fundamentem większości stron internetowych. Jeśli chodzi o konkrety - ja osobiście używam do przeglądania Firefoxa, natomiast dla usług wybrałem SeaMonkey (przeglądarkę, która w prostej linii jest kontynuacją Mozilla Suite). Eksperymentowałem z Google Chrome, jednakże jak dla mnie jest to przeglądarka o zbyt prymitywnym interfejsie i możliwościach konfiguracji. Co więcej, podczas działania w Sandboxie zawieszała się kilka razy dziennie, co zdyskwalifikowało ją kompletnie. Najchętniej korzystałbym z dwóch Firefoxów, jednakże jest to niemożliwe technicznie - proces Firefoxa może być tylko jeden w systemie. Fakt - mogę uruchomić go z konta innego użytkownika, ale wtedy nie byłby w Sandboxie, który działa tylko dla aktualnie zalogowanego użytkownika. Wybrałem więc starą, dobrą Mozillę, którą miło wspominam jeszcze z początku dekady, gdy w wersjach 1.x w tamtym czasie była o całe lata świetlne w rozwoju przed konkurencją (co ciekawe, wydaje mi się, że SeaMonkey jest szybszy od Firefoxa)

Wiem, jak na implementację zasady security by isolation to trochę za mało. Co prawda Sandboxie skutecznie utrudnia wprowadzenie jakiegokolwiek złośliwego oprogramowania do mojego komputera, to jednak nie chroni przed wszystkimi scenariuszami. Można sobie wyobrazić rozwiązanie, które wyexploituje mi przeglądarkę, odczyta pewne dane z mojego dysku i gdzieś je od razu prześle. Przed czymś takim Sandboxie nie chroni. Najlepiej byłoby używać różnych wirtualnych maszyn do różnych czynności, tak jak proponuje Joanna Rutkowska. Wówczas wyexploitowanie jednej z nich nie spowoduje żadnych strat, co więcej, nie będzie trwałe, bo maszyny po użyciu przywraca się do stanu zapamiętanego migawką. Niestety wadą takiego rozwiązania jest to, że byłoby to zbyt powolne i kłopotliwe przy użyciu komputera o przeciętnych parametrach. Teoretycznie idealnym rozwiązaniem byłoby stosowanie systemu operacyjnego Qubes OS tworzonego przez firmę Joanny Rutkowskiej - Invisible Things Lab. System ten zbudowany jest na hypervisorze Xen i automatyzuje tworzenie i uruchamianie maszyn wirtualnych, tak jakby były zwykłymi programami. Jednakże jak na razie jest to rozwiązanie we wczesnej wersji rozwojowej i nie nadaje się do pracy jako system operacyjny ogólnego przeznaczenia.

Unikam ciasteczek

Dosyć poważnym zagadnieniem jest skala zbierania i przetwarzania informacji o użytkownikach przez takie firmy jak Google. Ciasteczko odpowiada za utrzymanie sesji przeglądarki internetowej ze stroną, umożliwia zauważenie przez serwer, że konkretne wejścia na stronę (i inne działania w ramach strony) wykonywane są przez tego samego użytkownika - posiadającego zapamiętane w przeglądarce ciasteczko. Google na przykład może analizować wpisywane przeze mnie słowa do wyszukiwarki i przyporządkować je do mojego konta jeśli jestem podczas wyszukiwania zalogowany. Tutaj dodatkowym plusem dwóch przeglądarek jest oddzielenie zalogowania na koncie Google (przeglądarka dla usług) od zwykłego wyszukiwania (przeglądarka “do przeglądania”). Fakt, cały czas jestem tym samym adresem IP. Jednakże współcześnie sam adres IP nie wystarczy do pełnego zidentyfikowania sesji użytkownika - wszak może to być ktoś zupełnie inny za moim NAT’em. Wracając do ciasteczek - ustawiłem swoje przeglądarki internetowe tak, aby kasowały ciasteczka po ich zamykaniu. Dzięki temu w pewnym stopniu utrudniam analizę danych na mój temat wprowadzając “szum” - każda odsłona powoduje utworzenie nowego ciasteczka, czyli teoretycznie chodzi o innego użytkownika. Gdzieś słyszałem, że jedno z ciasteczek ustawianych przez wyszukiwarkę Google ma okres ważności do 2020 roku. Możecie sobie, drodzy czytelnicy, wyobrazić komu i do czego potrzebne są analizy aktywności użytkownika w tak długim czasie? Usuwanie ciasteczek nie wpływa znacząco na obniżenie wygody, jedynie zmusza nas do zrezygnowania z opcji typu “zapamiętaj mnie” podczas logowania na stronach, której i tak nie powinno się używać.

W temacie ciasteczek warto wspomnieć również o innej ich kategorii, mianowicie o ciasteczkach wtyczki Flash. Pełnią one taką samą funkcję jak zwykłe ciasteczka, mają większe możliwości i bardzo niewiele osób o nich wie. Szczegółowy opis problemu jest na blogu Piotra Koniecznego. Warto więc wyłączyć również i te ciasteczka za pomocą opcji dostępnych po kliknięciu prawym przyciskiem myszki na dowolnej animacji Flash.

Unikanie ciasteczek jest ważnym aspektem prywatności przeglądania stron internetowych, ale jeżeli ktoś się bardzo postara to i tak może spróbować nas zidentyfikować. Przykładowo istnieją metody wyciągania wniosków z tego, jakimi wtyczkami i jakimi czcionkami nasza przeglądarka może “pochwalić się” serwerowi. Projekt Panopticlick pokazuje jak bardzo unikatowy jest zestaw możliwości naszej przeglądarki. Konfiguracja taka jak moja zdarza się raz na milion według tej strony, co trochę mnie martwi. Co ciekawe, według powyższej strony ta moja unikatowość “generowana” jest przez dość skromny zestaw wtyczek - najnowsze wersje środowiska Java, czy Adobe Flash. Czyżby rzeczywiście tak niewielu użytkowników dbało o aktualność swojego oprogramowania? Jeszcze inną “magiczną” sztuczką jest próba wnioskowania czegoś o historii przeglądanych stron korzystając z możliwości ustawienia różnego wyglądu dla elementów wcześniej odwiedzonych. Przykładem takiej techniki jest strona, za pomocą której można robić znajomym dowcipy: didyouwatchporn.com. Technicznie działa to w ten sposób, że można zdefiniować za pomocą CSS, żeby link do strony X zawierał obrazek w przypadku gdy X była odwiedzona (klasa :visited). Jeżeli serwer odnotuje pobranie obrazka, wyciągamy wniosek, że użytkownik odwiedził stronę X. Moim zdaniem jednak powyższe mechanizmy nie odgrywają dużej roli, ponieważ de facto są pewnym rodzajem heurystyk i nie dają gwarancji zidentyfikowania użytkownika. To trochę tak jakby np. próbować zidentyfikować kogoś na podstawie koloru i wyposażenia jego samochodu. Fakt, zestaw typu (marka, kolor, silnik turbodiesel, przyciemniane szyby, alufelgi) może być dość unikatowy, ale przecież na tej podstawie nie można mieć stuprocentowej pewności co do identyfikacji konkretnej osoby.

Adobe i “spółka” jest większym problemem niż się wydaje

Programy firmy Adobe - mam tu na myśli wtyczkę Flash oraz czytnik plików PDF Adobe Reader w ostatnim czasie są coraz częstszym obiektem ataków. Niemalże każda kolejna wersja Reader’a zawiera jakąś krytyczną poprawkę naprawiającą błąd, który mógł spowodować zainstalowanie złośliwego oprogramowania w naszym komputerze tylko w wyniku samego otwarcia pliku PDF. Podobnie jest z odtwarzaczem animacji Flash (analogicznie - samo wejście na stronę z animacją mogło wyrządzić nam krzywdę). Wielu nietechnicznym użytkownikom trudno jest uświadomić konieczność aktualizacji systemu operacyjnego czy przeglądarki, nie wspominając już o konieczności aktualizacji “dodatków” firmy Adobe, z czego mało kto sobie zdaje sprawę. A jest to tak samo ważne, ponieważ wiąże się z tymi samymi zagrożeniami. Adobe Reader jest programem wyjątkowo nieprzyjemnym, chociażby dlatego, że instaluje się dodatkowo w przeglądarce jako wtyczka powodująca automatyczne otwieranie pliku PDF w oknie przeglądarki bez pytania o zgodę. W związku z tym, jeżeli już używamy Adobe Readera polecam wyłączyć tę wtyczkę do przeglądarki, aby ręcznie pobierać plik PDF i ręcznie otwierać. Osobiście rozważam zrezygnowanie z Adobre Reader’a na rzecz np. Sumatra PDF albo Foxit. Tymczasem, jeżeli trzeba używać Adobe Readera - polecam uruchamiać go również przez Sandboxie. Powyższe zalecenia dot. konieczności aktualizacji dotyczą również innych “dodatków” do przeglądarki jak np. środowiska Java. Dbanie o używanie aktualnych wersji oprogramowania powinno w świadomości użytkowników komputerów stać się niezbędnym elementem “konserwacji” swojego komputera takim samym jak na przykład wymiana oleju w przypadku samochodu (tu chyba nikt nie ma wątpliwości, że jest to konieczne).

Do naprawdę wrażliwych operacji warto jednak mieć maszynę wirtualną

Do operacji bankowych używam właśnie Xubuntu uruchamianego w Oracle VirtualBox. Po każdym uruchomieniu przywracam dysk maszyny do wcześniej zapamiętanego stanu, dzięki temu przez cały czas mam taki sam, “czysty” system. Gdyby jakimś cudem w moim komputerze znalazło się oprogramowanie np. przechwytujące naciśnięcia klawiszy - to nie przechwyci ono tego, co się wpisuje wewnątrz maszyny wirtualnej. Sprawdzałem działanie mechanizmu Hooks w systemie Windows - faktycznie “haki” przechwytujące naciśnięcia klawiszy nie “wyłapują” tego, co się dzieje w maszynie wirtualnej. Jest to więc bardzo silne i skuteczne rozwiązanie praktycznie uniemożliwiające przedostanie się jakiegokolwiek złośliwego oprogramowania zarówno w kierunku mój system operacyjny -> maszyna wirtualna, jak również w odwrotnym kierunku, ponieważ zakładam, że tej maszyny używam tylko do łączenia się z witryną banku. W przyszłości zamierzam jeszcze wdrożyć pomysł Joanny Rutkowskiej i zmodyfikować wirtualną sieć, tak, aby ta konkretna maszyna mogła łączyć się tylko z jednym adresem IP (zastanawiam się właśnie jak ona to zrobiła, podejrzewam, że w VMware efekt ten można uzyskać za pomocą narzędzia konfiguracji sieci dostępnego przez skrót Manage Virtual Networks)

PS. Platformie blogowej blox.pl gratuluję ograniczenia długości wpisu do 16KB. Ostatnią sekcję tego tekstu musiałem wkleić jako obrazek…

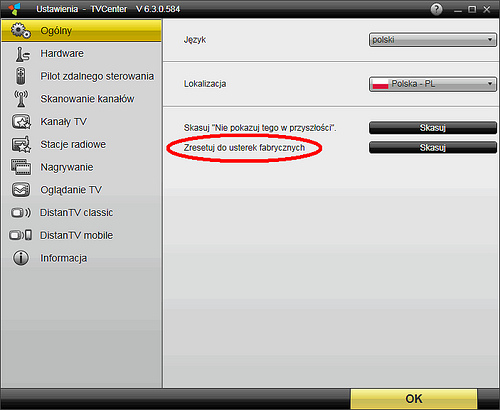

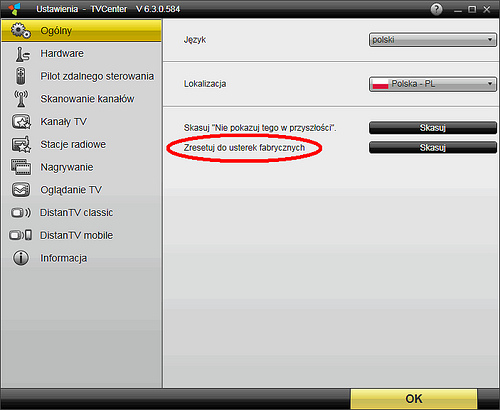

Na szczęście to nie ja dostąpiłem wątpliwego zaszczytu bycia tym użytkownikiem, tylko kolega (pozdr. dla Vincenta i dzięki za info). Poniższy obrazek to podobno tylko wierzchołek góry lodowej jeśli chodzi o kłopoty z programami do obsługi urządzeń tej firmy.

Zaintrygowało mnie eleganckie zapewnienie na stronie logowania czołowego niegdyś, polskiego serwisu społecznościowego: “Logujesz się bezpiecznie przez SSL”. Serwisy internetowe często stosują technikę polegającą na szyfrowaniu jedynie strony z formularzem do logowania, a przechodząc do właściwych stron serwisu zmieniają połączenie na zwykłe http (skoro nie dajemy rady ochronić wszystkich twoich danych, to zabezpieczymy przynajmniej twoje hasło). Myślałem, że tak jest i tym razem, chociaż nie widziałem typowego w takich sytuacjach mignięcia paska adresu na żółto w krótkiej chwili, gdy połączenie jest szyfrowane.

Aby się upewnić włączyłem w mojej przeglądarce ostrzeżenie przy otwieraniu zaszyfrowanej strony: w Mozilla Firefox - opcje -> bezpieczeństwo -> ostrzeżenia -> ustawienia: wyświetlaj ostrzeżenie przy “otwieraniu zaszyfrowanej strony”. Podczas logowania do serwisu, ostrzeżenie wbrew obietnicom napisanym pogrubioną czcionką nie pojawia się, co oznacza tyle, że połączenie wcale bezpieczne nie jest.

Jakie to ma praktyczne konsekwencje? Szczerze mówiąc niewielkie o ile nie łączymy się z Internetem np. poprzez ogólnodostępny, darmowy “hot-spot” gdzie istnieje realna szansa podsłuchania całego ruchu w sieci w bardzo prosty sposób. Głównym celem szyfrowania połączenia ze stroną internetową jest zapewnienie, że jeżeli ktoś, kto “po drodze” od naszej przeglądarki do serwera ze stroną internetową uzyska dostęp do medium transmisyjnego, to jednak nie uzyska dostępu do danych. W przypadku niezabezpieczonych sieci bezprzewodowych niebezpieczeństwo jest duże, dlatego, że taki podsłuch jest właśnie trywialnie prosty - wszak nośnikiem jest eter. W przypadku połączenia kablowego (pomijając infrastrukturę sieci lokalnej w szkole/uczelni/pracy, która może być tak zbudowana, że podsłuch jest możliwy w jej obrębie) niebezpieczeństwo przechwycenia niezaszyfrowanych danych na drodze od naszego usługodawcy internetowego do serwera docelowego jest raczej średnie, ponieważ byłoby po prostu dość skomplikowane technicznie (ale jak najbardziej możliwe).

Jakie to ma inne konsekwencje? Tylko wizerunkowe. Nie podoba mi się to, że serwis mnie oszukuje już na powitanie.

U konkurencji jest lepiej, bo:

NK zapewnia oddzielny link do logowania przez SSL widoczny na stronie głównej

FB zapewnia szyfrowanie SSL, gdy w pasku adresu ręcznie podmienimy http na https. Jednakże na stronie głównej nie informuje o takiej możliwości. Co ciekawe, szyfrowanie jest domyślne podczas edytowania danych swojego konta, co trochę dziwi wobec nie szyfrowania samego logowania do serwisu.

Deklarowałem się, że nie będę podawać na blogu news’ów, ale ta informacja jest dosyć istotna dla osób korzystających z wirtualizacji, a nie została zauważona w żadnym z serwisów, które śledzę.

Od ok. 2 lat używam i polecam znajomym program Sun Virtualbox. Jest to narzędzie darmowe posiadające wszystkie niezbędne funkcje. VMware Player do wersji 3 był programem pozwalającym jedynie na uruchamianie istniejących maszyn, a nie ich tworzenie. Natomiast od wersji 3 wprowadzono również możliwość tworzenia nowych maszyn. Oznacza to, że do grupy darmowych, w pełni funkcjonalnych programów można zaliczyć również VMware Player’a. Różnicą w stosunku do płatnego Workstation jest brak możliwości tworzenia migawek (swoją drogą pamiętam, że w Workstation kiedyś dawno temu też tego nie było) oraz brak jakichś mało użytecznych dla skromnego użytkownika funkcji do pracy w grupie.

Testowałem VMware Player na razie tylko w wersji dla systemu Linux i w moim odczuciu działa znacznie wydajniej od Sun Virtualbox’a. Przykładowo odtwarzanie filmów z Youtube działa (system gościa to Windows) całkowicie płynnie, czego o maszynie w Virtualbox powiedzieć nie można. Zapewne dzięki wsparciu dla przyspieszenia sprzętowego w wyświetlaniu grafiki.

Pisałem już na blogu o tym, że nie lubię GG. Nie jest to opinia umotywowana typowo polską skłonnością do narzekania na wszystko. Uważam, że trudno jest lubić program służący do komunikacji w czasie rzeczywistym, który:

Wyświetla irytujące, nachalne reklamy we wszystkich możliwych miejscach (sugeruję umieszczanie reklam dodatkowo również pomiędzy znakami przesyłanych wiadomości, bo tam ich jeszcze nie było)

Ma interfejs przeładowany bezużytecznymi funkcjami (ktoś wie do czego służy GG Rodzina albo GG Zamawianka? Ja nie wiem i ta wiedza nie jest mi do szczęścia potrzebna)

Ma po prostu źle wykonane archiwum. Przynajmniej u mnie czas załadowania się archiwum to kilkanaście sekund przy pełnym obciążeniu procesora. Bez przesady - można to zrobić efektywniej

Potrafi od czasu do czasu nie dostarczyć wysłanej wiadomości

Może się pochwalić jakże bogatym zbiorem wyników po wpisaniu w Google: gg cenzura. Niestety istnieją zaobserwowane przypadki blokowania treści przesyłanych przez sieć GG

W mojej ocenie zarzuty te (w szczególności dwa ostatnie) są dyskwalifikujące dla tego programu jako rozwiązania typu instant messaging.

Szeroko stosowanym i polecanym przez profesjonalistów rozwiązaniem jest dowolny program korzystający z protokołu XMPP zwanego dawniej Jabber:

Jest to standard otwarty, tzn. nie należy do żadnej firmy i każdy może “postawić” swój serwer tego protokołu

Zmierza w stronę oficjalnego standardu internetowego RFC

Istnieje bardzo dużo programów do jego obsługi, wybór jest ogromny

Jest sprawdzony i niezawodny

Jest darmowy i niekomercyjny

Ma szereg funkcji niedostępnych w GG

Nie istnieje przykra konieczność poddawania się kaprysom firmy produkującej program np. zmuszanie do aktualizacji, zmuszanie do oglądania reklam, zmuszanie do korzystania z programu w taki sposób, jaki wymyślą sobie wizjonerzy firmy. W przypadku XMPP korzystamy z takiego programu, jaki nam się podoba

Niestety główna zaleta GG jest jednocześnie główną wadą XMPP/Jabbera: baza użytkowników. Co z tego, że ja bym go chętnie używał skoro musiałbym rozmawiać chyba sam ze sobą? Zwykli użytkownicy komputerów niestety o nim nie słyszeli i korzystają z GG, bo jak wiadomo z GG korzystają wszyscy. W lutym br. Facebook wykonał moim zdaniem niezwykle trafną operację, która może coś w tej dziedzinie zmienić, a mianowicie:

Facebook udostępnił dla każdego użytkownika serwisu konto na swoim własnym serwerze XMPP. Rozmowy prowadzone w ten sposób są tym samym, co dostępny w serwisie chat tzn. możemy używać do rozmowy chatu lub swojego ulubionego programu obsługującego XMPP. Korzyści są na przykład takie:

Aby rozpocząć korzystanie nie trzeba zakładać żadnego konta. Wystarczy wybrać program, ja polecam Pidgin

Konfiguracja jest trywialna. Wystarczy jako serwer (dla konta XMPP, w Pidginie pod nazwą “domena”) wpisać w programie chat.facebook.com, podać nazwę użytkownika i hasło a w opcjach zaawansowanych odznaczyć szyfrowanie SSL (niestety nieobsługiwane) i to wszystko

Od tego momentu można korzystać z chatu FB w swoim ulubionym programie. Konto XMPP jest niezależne od zalogowania w serwisie Facebook. Można mieć jednocześnie otwarty Pidgin oraz przeglądarkę ze stroną FB. Widać, że zmiany (dostępność znajomych) pojawiają się szybciej w programie niż na stronie. Ponadto można również korzystać z programów na telefony komórkowe np. Parlingo.

Facebook załatwia nam problem tego, że z XMPP korzysta mało użytkowników, czyli likwiduje jego największą wadę. Gdyby poinformować użytkowników Facebook’a, że w ten sposób mogą wykorzystać swoje konto, do tego, aby mieć pełnowartościowy, lepszy od GG komunikator to myślę, że coraz więcej osób mogłoby zrezygnować z wątpliwych usług żółtego słoneczka.

Dysk twardy należy do tych części systemu komputerowego, których działanie jest uzależnione od elementów mechanicznych. A elementy mechaniczne, nawet gdy są najwyższej jakości, będą ulegać awarii częściej niż elementy elektroniczne. Chciałbym podzielić się kilkoma spostrzeżeniami na temat skutków awarii oraz metod zabezpieczania się przed nimi.

Najczęstszym objawem trwałego uszkodzenia dysku jest pojawienie się tzw. bad sectorów. Krótko mówiąc są to obszary na dysku, które uległy fizycznemu uszkodzeniu i nie można odczytać i/lub zapisać na nich danych. Obszary te mogą mieć bardzo różny rozmiar, przykładowo widziałem raz uszkodzenie długości zaledwie 11 bitów (polecam narzędzie SpinRite). Rodzaj skutków takiego uszkodzenia ściśle zależy od tego, w którym miejscu ono wystąpi. Jest to oczywiście zupełnie losowe. Można wyróżnić takie przypadki:

W miejscu oznaczonym jako wolne: wówczas nic złego się nie stanie. O ile awaria zostanie w porę zaobserwowana np. poprzez monitoring S.M.A.R.T. albo skanowanie powierzchni dysku programem sprawdzającym, ważne dane skopiowane, a dysk wycofany z użycia. Sprawą oczywistą jest to, że praca na dysku z uszkodzeniem fizycznym prędzej czy później zakończy się jego kompletną “wysiadką”.

W miejscu, w którym znajduje się plik, ale niekrytyczny dla systemu operacyjnego. Wówczas też nic złego się nie stanie, o ile, podobnie jak w (1), awaria zostanie zauważona.

W miejscu, w którym znajduje się plik należący do systemu operacyjnego. W tym momencie zaczynają się już poważne skutki. Trudno przewidzieć co się może dziać, ale system o ile w ogóle się uruchomi, to w najlepszym wypadku będzie się zachowywał dziwnie. Zanim zacznie się przeklinać producenta systemu dobrze jest upewnić się czy na dysku nie pojawił się właśnie bad sector. Należy użyć stosownych narzędzi do sprawdzania dysku i jak najszybciej skopiować cenne dane. Warto wiedzieć, że w systemie Windows awarie dysku można również zauważyć w dzienniku systemu (eventvwr.msc) jako błąd pochodzący od “disk” o komunikacie jednoznacznie wskazującym, że dyskiem nie jest dobrze (swoją drogą podobny komunikat może pojawić się w przypadku problemów z aparatem fotograficznym, kartą pamięci, pendrive’em etc. Wtedy nie należy się bać, bo przyczyną może być np. wadliwy kabel - trzeba upewnić się kiedy te błędy się pojawiają, czy zdarza się to podczas podłączenia np. aparatu do komputera). Należy również cieszyć się, że dostęp do danych jest w ogóle możliwy, bo w ostatnim przypadku.

W miejscu, w którym znajduje się tzw. superblok systemu plików, czyli struktura opisująca fizyczną organizację danych w pliki na dysku. Widziałem kiedyś taki przypadek, że bad sector “trafił” w obszar MFT partycji NTFS. W takiej sytuacji przestaje być możliwy dostęp do systemu plików (w jakikolwiek sposób - zapomnij o sztuczkach z ratunkowymi dystrybucjami Linuxa). Jeżeli stało się to na partycji systemowej to objaw jest taki, że system wyświetla na czarnym ekranie enigmatyczny komunikat o błędzie odczytu (niestety nie pamiętam treści) i komputer zawiesza się. Komunikat jest na czarnym, a nie słynnym niebieskim ekranie, bo BSOD jest komunikatem o błędzie jądra, a tutaj jądro nie zostało jeszcze załadowane, ponieważ 16-bitowy kod bootloader’a nie był w stanie otworzyć systemu plików partycji systemowej. W tej sytuacji można pożegnać się z danymi na dysku (dokładniej: partycji). Aczkolwiek podejrzewam, że firmy specjalizujące się w odzyskiwaniu danych potrafią binarnie grzebać w partycji NTFS (jest to robota porównywalna do szukania igły w stogu siana, dosłownie), ale koszt takiej usługi zapewne jest astronomiczny.

Widok przypadku (4) był dla mnie bardzo pouczający. Warto sobie uzmysłowić, że coś takiego w ogóle może się zdarzyć (fakt, dysk miał wyjątkowego pecha) i, że skutki są aż tak katastrofalne. Na tej podstawie można wywnioskować, że bezpieczniej jest mieć wiele partycji na dysku niż jedną dużą. W przypadku jednej dużej, gdy nastąpi awaria typu (4) tracimy zwartość całego dysku. Gdy natomiast mamy wiele partycji, tracimy zawartość tylko tej, w którą “trafiło”.

Chciałbym poruszyć jeszcze zagadnienie macierzy RAID. Moje refleksje w tym temacie są takie, że pomimo dostępności tego typu rozwiązań w domowych komputerach, są one raczej mało użyteczne.

RAID 0. Stosowanie tego poziomu jest raczej bez sensu z punktu widzenia bezpieczeństwa. Zwiększa się prawdopodobieństwo awarii i utraty danych kosztem większej wydajności.

RAID 1. Stosowanie tego poziomu w domowym komputerze jest wątpliwe, ponieważ chyba nie ma wielu osób, które chciałyby kupić 2 dyski a mieć dostępną przestrzeń tylko jednego.

RAID 0+1, albo 1+0. W domowych warunkach odpada, ze względu na zbyt dużą minimalną liczbę potrzebnych dysków - aż 4.

RAID 5. W najnowszych płytach głównych poziom ten jest dostępny w sprzętowych kontrolerach. Jest to szeroko stosowane rozwiązanie w sieciowych urządzeniach pamięci dyskowych oraz modularnych macierzach dyskowych. Poziom ten charakteryzuje się bardzo dobrymi parametrami, ale również wymaga zbyt wielu (tak sądzę), jak na domowy komputer, dysków: 3 dając dostęp do przestrzeni dwóch.

Moim zdaniem najlepszym rozwiązaniem dla domowego komputera jest montaż dwóch dysków twardych, na każdym z nich instalacja oddzielnego systemu operacyjnego oraz ręczne kopiowanie najważniejszych danych w taki sposób, aby zawsze były w aktualnej postaci na obu dyskach. Rozwiązanie to ma szereg zalet:

Mamy dostępną przestrzeń obu dysków, nie występuje problem np. RAID’u 1 gdzie de facto kupujemy 2 dyski a “mamy” 1.

Zabezpieczamy się przed awariami (1), (2) i (3) ponieważ w przypadku awarii któregokolwiek dysku mamy gotowy do działania drugi system operacyjny, który możemy uruchomić i użyć do uratowania danych z uszkodzonego dysku.

Dodatkowo zabezpieczamy się przed programową awarią samego systemu operacyjnego. Gdy jeden z systemów odmówi posłuszeństwa, po prostu uruchamiamy drugi i mamy możliwość dalszej pracy.

Zyskujemy możliwość wygodnego wykonywania kopii zapasowej również takich plików, które są zablokowane podczas działania systemu operacyjnego. Można uruchomić drugi system, np. Linux i na wszelki wypadek zrobić kopię zapasową pierwszego systemu operacyjnego np. Windows’a, bo planujemy wykonywać na nim jakąś ryzykowną operację, którą warto byłoby móc przywrócić.

Sam stosuję takie rozwiązanie, że na obu dyskach mam działający program rozruchowy, dzięki temu w każdej chwili mogę odłączyć dowolny z dysków i drugi pozwoli na uruchomienie znajdującego się na nim systemu. Na jednym dysku mam system Windows zainstalowany standardowo, na drugim mam system Linux z menedżerem rozruchu GRUB uwzględniającym oba systemy. Dysk z systemem Linux jest dla komputera pierwszym urządzeniem do rozruchu dzięki czemu mogę wybierać między dwoma systemami. Gdyby dysk ten uległ awarii, mogę przełączyć drugi dysk na główne urządzenie rozruchowe i bez wprowadzania jakichkolwiek dodatkowych zmian pracować w systemie Windows. Analogicznie, gdyby dysk z system Windows się zepsuł, mogę o nim zapomnieć i pracować w systemie Linux.

Podsumowanie będzie krótkie: dbajmy o to, aby najważniejsze dla nas dane przechowywać na co najmniej dwóch, niezależnych fizycznych nośnikach. Doświadczenie pokazuje, że awarie zdarzają się zwykle właśnie tym użytkownikom, którzy nie robią kopii zapasowych :)

Postanowiłem wypowiedzieć się na ten temat na blogu, ponieważ różne “czarodziejskie” sposoby usuwania śledzika cieszą się wciąż niemałą popularnością, pomimo, że ich skuteczność była, jest i będzie zerowa. Niezerowe są natomiast zyski sprytnych osób wykorzystujących wiarę użytkowników w to, że mało użyteczna funkcjonalność zniknie z ich profilu w serwisie NK. Pokażę tę pomysłowość na konkretnym przykładzie.

Najpierw jednak kilka słów o tym dlaczego śledzik nie zniknie. Przede wszystkim ze względów biznesowych. Wprowadzenie tej funkcjonalności do serwisu NK było sporym przedsięwzięciem, nad którym pracowało wiele osób i które z całą pewnością było kosztowne. Hipotetyczna decyzja zarządców serwisu o usunięciu śledzika (przynajmniej w tak krótkim czasie od jego wprowadzenia) byłaby równoznaczna z wyrzuceniem do śmieci wyników pracy zespołu twórców oraz zmarnowaniem wszelkich innych włożonych w to nakładów. Moim zdaniem to oczywiste, że taka decyzja nie zostanie podjęta. Aczkolwiek niewątpliwie sam pomysł okazał się niewypałem, sądząc po reakcji użytkowników. W polskim internecie funkcjonują już mikroblogi z prawdziwego zdarzenia jak blip.pl czy moblo.pl. Okazuje się, że coś takiego w ramach NK nie bardzo spełnia swoje zadanie, natomiast jedynie zajmuje miejsce na stronie głównej.

Dla jasności dodam jeszcze, że wszelkie odprawianie czarów w rodzaju wpisywania kodów takich jak J3273M-D38113M do okienka tekstowego śledzika jest z góry skazane na porażkę. Praktycznie jest to niemożliwe technicznie, aby wprowadzenie jakiegokolwiek ciągu do okienka śledzika było zinterpretowane przez serwer i spowodowało niewyświetlanie wybranym użytkownikom pola śledzika. Ustawienia są wprowadzane przez użytkownika na przeznaczonej do tego stronie. Gdyby serwer miał analizować wprowadzone przez użytkownika ciągi znaków (co przy takiej liczbie użytkowników jest zadaniem wymagającym obliczeniowo) w poszukiwaniu jakiegoś kodu tylko po to, aby zmienić jakąś hipotetyczną właściwość użytkownika np. “Wyświetlaj śledzika” z wartości “prawda” na “fałsz” - to byłoby to rozwiązaniem totalnie idiotycznym.

A teraz spojrzenie z innej strony. W dwóch poprzednich akapitach przekonywałem, że śledzik nie zniknie “systemowo”, w tym natomiast pokażę, że zniknąć może - dla nas jako użytkowników. Oczywiście z tego co napisałem wcześniej wynika, że nie możemy zmusić serwera, żeby nie wysyłał do naszej przeglądarki strony bez śledzika. Możemy jednak zmusić naszą przeglądarkę, żeby ona nam go nie pokazywała. Sprytni użytkownicy zauważyli, że pole śledzika w kodzie strony ma nazwę _sledzik_boxi wystarczy użyć narzędzia filtrującego reklamy, aby nie pokazywać śledzika. Rozwiązanie takie jest opisane tutaj. Mniej zaawansowanych użytkowników uspokajam, że jest to rozwiązanie wyjątkowo banalne do zastosowania (sprawdziłem, działa).

Na koniec obiecany przykład kogoś bardzo sprytnego, kto autentycznie zarabia pieniądze, na tym, że użytkownik NK myśli, że usunie sobie śledzika. Poniżej zrzut ekranu ze strony http://śiedzik.pl/usun/ do której link rozprzestrzenia się właśnie za pomocą śledzika. Jestem rzeczywiście pod wrażeniem pomysłu jak łatwo można zarobić na czyjejś naiwności. Przedstawię zatem ten średnio uczciwy (autor obiecuje, że śledzik zniknie, a jak wiemy, nie zniknie - więc moim zdaniem podchodzi to pod formę oszustwa) mechanizm .

Nazwa: Śiedzik.pl. Znana sztuczka, głównie przestępców z kategorii phisherów, polegająca na wymyśleniu takiej nazwy strony, której wizualny układ liter łudząco przypomina oryginał. Ulubionym mechanizmem jest tutaj podobieństwo litery “i duże” do “l małe”. Dodatkowo oprawa graficzna żywcem przeniesiona z oficjalnej strony śledzika potęguje wrażenie, że mamy do czynienia z firmowym narzędziem do pozbycia się uciążliwego mikroblogu.

Najlepszy pomysł - autor zakłada, że gdzieś obok jesteśmy zalogowani do NK. Wciśnięcie przycisku powoduje umieszczenie na naszym śledziku linku do strony. Mamy więc tutaj mechanizm rozgłaszający informację o istnieniu strony.

Liczba osób odwiedzających. Ten element jest ważny dla reklamodawców. Zanim zapłacą za reklamę muszą zobaczyć liczbę. Jest ona duża. Duża liczba odwiedzających = duża oglądalność = większa cena za reklamę.

Reklamy. Aż trzy, autor jest jak widać zachłanny na zyski z reklam. Co w końcu nie jest dziwne - trzeba zarobić jak najwięcej w jak najkrótszym czasie, zanim potencjalny odwiedzający nie przeczyta na przykład tego tekstu i nie rozejdzie się informacja o tym, że jest to ściema. Autor najzwyczajniej w świecie sprzedaje przestrzeń reklamową na tej stronie. Z wymienionych wyżej przyczyn, jest to dobre miejsce na reklamę ponieważ odwiedzi je dużo osób.

Zwracam uwagę na bardzo zręczny pomysł samonapędzającej się promocji strony. Klikając w ten przycisk wklejamy link do strony na swojego śledzika, przez co zobaczą go nasi znajomi i zapewne też klikną w link zwiększając tym samym liczbę odwiedzin i dochód za reklamy, ponieważ skoro już tu weszli, zapewne chcą usunąć śledzika więc klikną w przycisk. - koło się zamyka.

Nie wiem ile jeszcze powstanie tego typu pomysłów w przyszłości, ale mam nadzieję, że chociaż w minimalnym stopniu przyczynię się do tego, że użytkownicy NK uwierzą wreszcie, że śledzik nie zniknie.

Ostatnio miałem okazję przetestować aplikację Ipla służącą do oglądania materiałów wideo. Jest to darmowy program za pomocą którego mamy możliwość oglądania materiałów zgromadzonych w katalogu Ipla (można oglądać tylko to co jest dostępne w katalogu, Ipla nie jest odtwarzaczem wideo). Użytkownicy konta płatnego mają możliwość oglądania kilku dodatkowych kanałów, w tym takich, które są transmitowane na żywo jak. np Polsat News; oraz mogą oglądać wideo w wyższej jakości.

Sama aplikacja jest wykonana solidnie, działa bez problemów na koncie zwykłego użytkownika w systemie Windows (jak wspominałem, z tym bywa różnie). Odtwarzanie przy najwyższej jakości pobiera dane z prędkością ok. 140 KB/s. Interfejs jest przejrzysty i łatwy w obsłudze, sprawia wrażenie dobrze zaprojektowanego - łatwo i szybko można zorientować się w dostępnych opcjach oraz hierarchii nagrań wideo.

Użytkownik ma do dyspozycji 5 kategorii tematycznych: seriale, rozrywka, wiadomości, sport. Można obejrzeć odpowiednio np. konkretny odcinek serialu (liczba materiałów wideo w kategorii seriale jest chyba największa), nagranie występu kabaretu, materiał z wiadomości Polsat, skróty meczów. Jest dostępna wyszukiwarka - co znacznie ułatwia odnalezienie danego materiału. Z pewnością wiele osób zada w tym momencie pytanie: co jest lepszego w korzystaniu z takiego oprogramowania od ręcznego wyszukiwania wideo np. w youtube i oglądania w przeglądarce? Moim zdaniem program jest z pewnością lepszy:

Nie mamy denerwującego ograniczenia długości materiału jak w youtube

Jest to program, który służy tylko do oglądania wideo i do tego został zaprojektowany - transmisja wideo jest stabilna, nie zdarzają się zacinanie odtwarzania, można swobodnie “poruszać” się po całej długości nagrania, mamy do dyspozycji aż 3 poziomy jakości - żadna z tych cech nie jest dostępna w przypadku oglądania filmów w przeglądarce.

Program posiada funkcjonalności społecznościowe - jest wbudowany komunikator, lista znajomych, można dowiedzieć się kto również ogląda dany przekaz.

Moim zdaniem jest to rozwiązanie warte polecenia, aczkolwiek w sensie usługi chyba trochę “niedojrzałe”. Przede wszystkim baza nagrań jest (jeszcze) zbyt uboga. Producent chwali się dostępnością “tysięcy” odcinków seriali - i faktycznie fani głupkowatych polskich produkcji nie będą zawiedzeni - ale jeśli chodzi o ciekawsze i bardziej ambitne materiały to już pojawia się problem. Video On Demand, bo do tej kategorii zalicza swój program producent, zawsze kojarzył mi się z możliwością obejrzenia pełnometrażowego filmu - jest to coś, czego oczekiwałbym od płatnej wersji usługi. Liczba kanałów transmitowanych na żywo (dostępnych tylko w wersji płatnej) jest na dzień dzisiejszy również bardzo skromna.

Podsumowując myślę jednak, że jest to usługa warta zwrócenia uwagi - Video On Demand jest w Polsce raczej we wczesnej fazie rozwoju i zapewne będzie się coraz dynamiczniej rozwijał. W Ipli jest spory potencjał, widać, że technicznie jest przygotowana bardzo dobrze i jeżeli rozwój pójdzie w kierunku powiększania oferty programowej to z całą pewnością będzie ona warta polecenia - myślę, że jest wielu użytkowników, którzy byliby gotowi skorzystać również z płatnej wersji po to, aby w naprawdę wygodny sposób obejrzeć sobie film.

![]()